主成分分析法

原理

主成分分析法(Principal Component Analysis,PCA)是一种统计方法。通过正交变换将一组可能存在相关性的变量转换为一组线性无关的变量,转换后的这组变量叫主成分。在数据科学和机器学习中,PCA常被用来进行降维处理。

PCA的主要目的:

数据压缩:减少数据集的维度,同时尽量保留原始数据的变异信息。

去噪:通过去除低方差的成分,可以有效降低数据中的噪声。

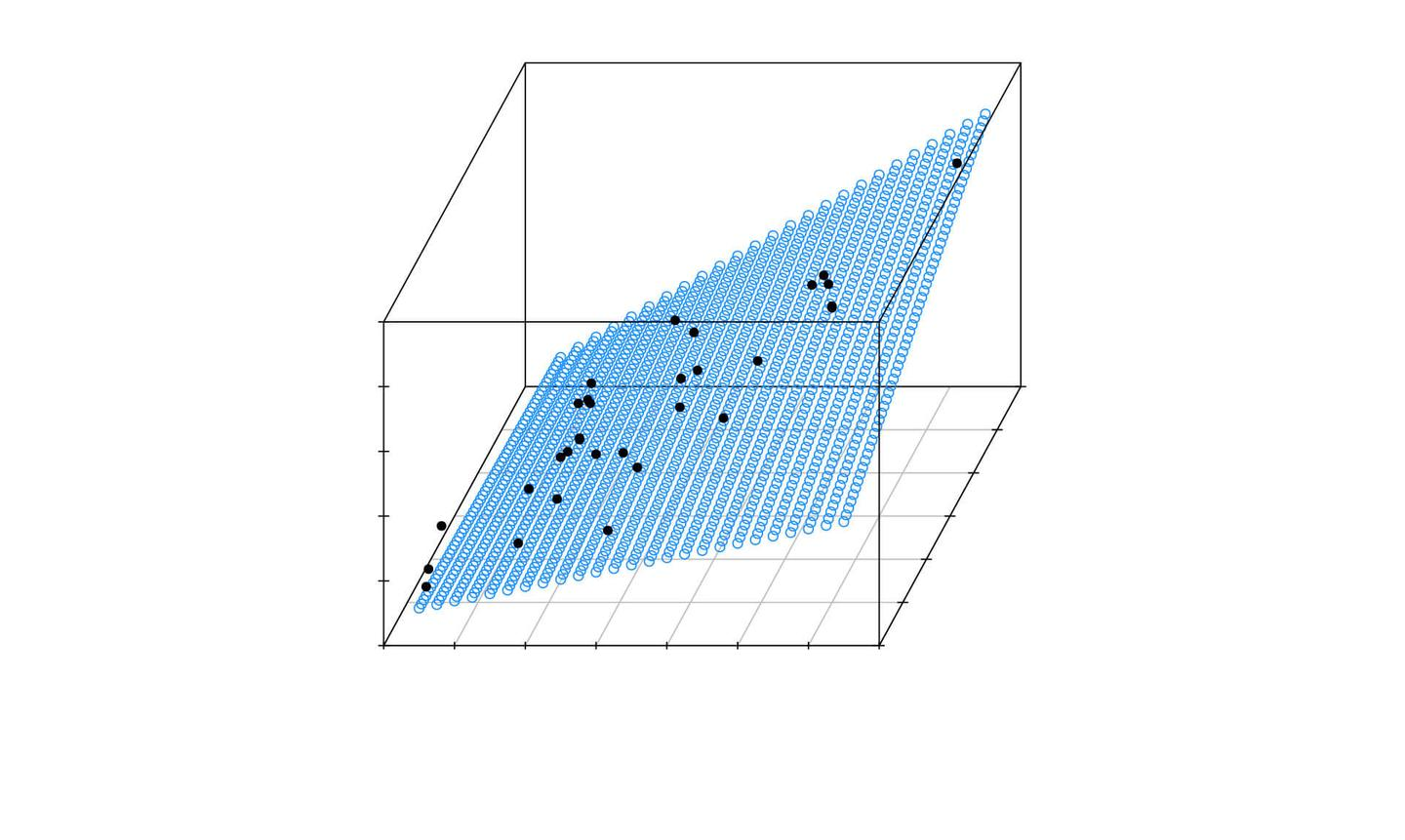

可视化:将高维数据转换到二维或三维空间中以便于可视化。

思想:

PCA的基本步骤:

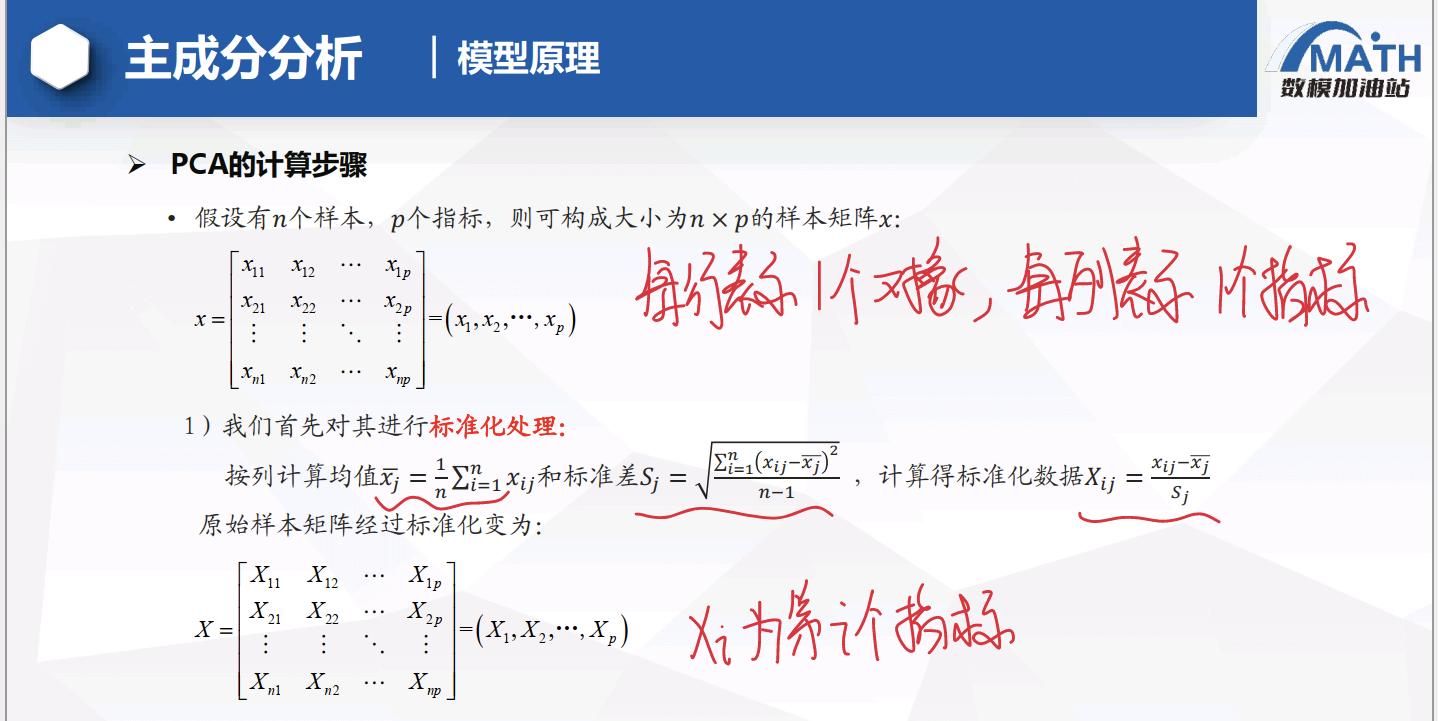

标准化数据:因为PCA对量纲敏感,所以需要对原始数据进行标准化,使得每个特征的均值为0,方差为1。

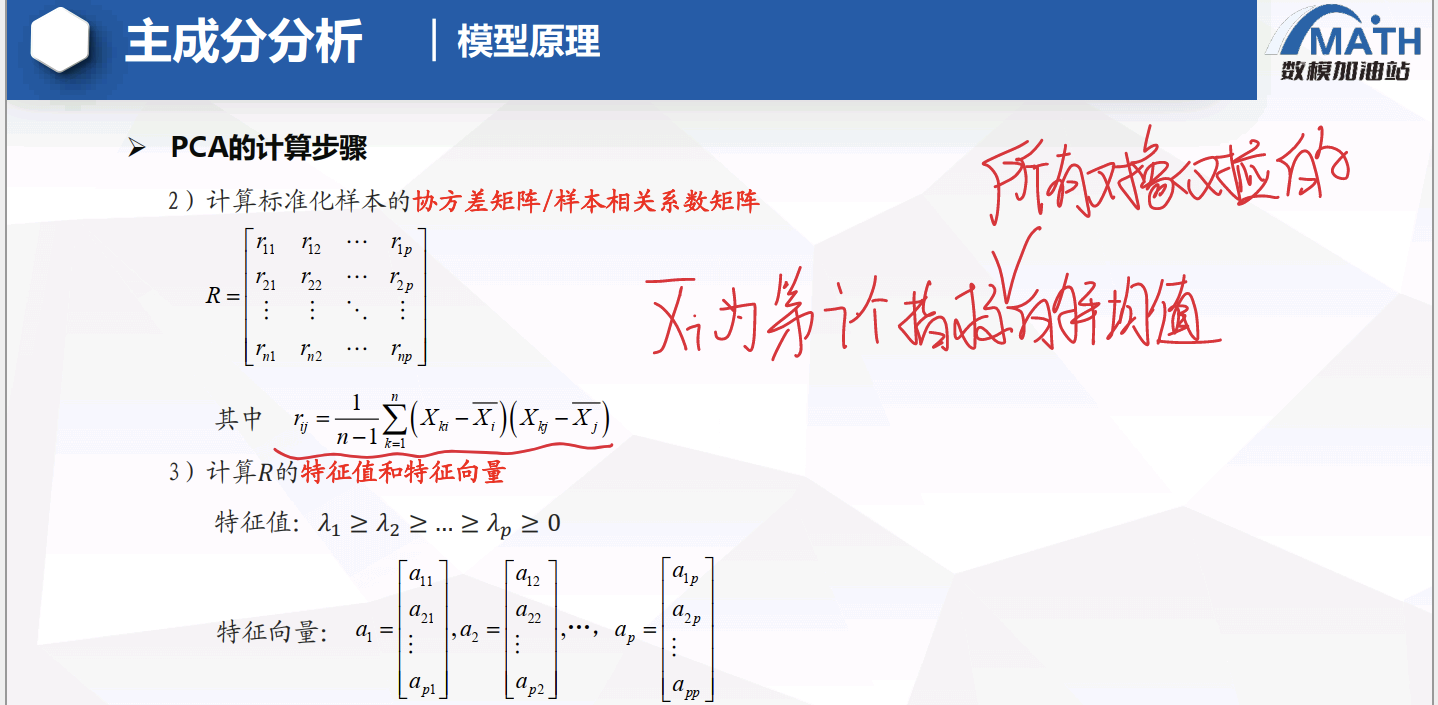

计算协方差矩阵:协方差矩阵能表示不同特征之间的关系以及它们的分布情况。

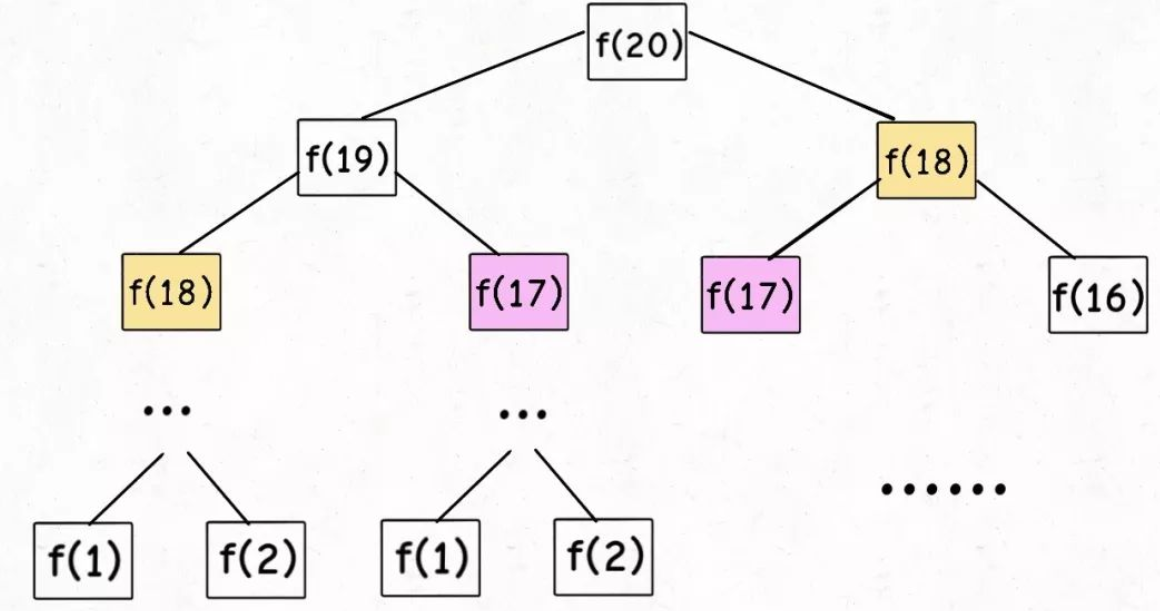

计算协方差矩阵的特征值和特征向量:特征值表示对应特征向量方向上的数据分散程度。

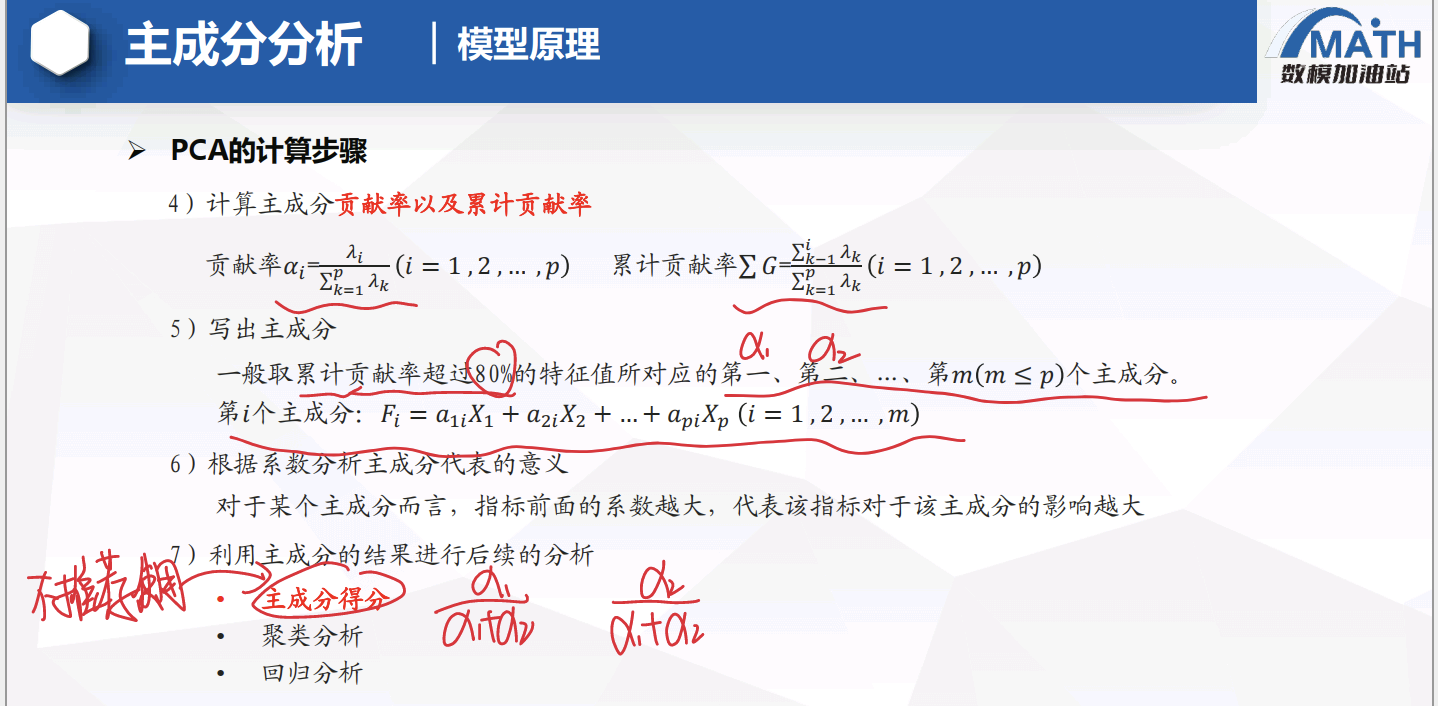

选择主成分:根据特征值大小排序,选择最大的几个特征值对应的特征向量作为主成分。这些主成分代表了数据的最大方差方向。

投影数据:将原始数据投影到由所选主成分构成的新坐标系中,得到降维后的数据。

计算步骤:

注意事项:

- PCA假设数据是线性相关的,并且新的成分是原始变量的线性组合。

- PCA是无监督的学习方法,它并不考虑类别标签信息。

- 降维后的主成分通常是不可解释的,因为它们是原始特征的线性组合。

代码

1 | clear;clc |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 Lee的学习之旅!